Самый короткий и самый понятный мануал по настройке robots.txt в WordPress. Оптимизируя свой веб-сайт для поисковых систем, вебмастера часто прибегают к редактированию robots.txt.

Но давайте начнем по порядку.

Что такое robots.txt и для чего он нужен?

Robots.txt — отвечает за отдачу команд поисковым роботам, таким как Google или Yandex. Он может как запрещать им что-то, так и разрешать. Настраивая данный файл, следует быть осторожным, так как вы можете нарушить индексацию вашего сайта. Чаще всего используются две команды Disallow — запретить и Allow — разрешить.

Но использование команды Disallow, не просто запрещает индексировать каталог, она запрещает заходить в него и смотреть, что там находится. Это считается «грубым» методом запрета.

Бывают исключения, когда нет других способов сообщить роботу о том, что не стоит индексировать содержимое той или иной странички. Чаще всего это касается различных интернет-магазинов. В таких случаях можно прибегать к блокировке через robots.txt.

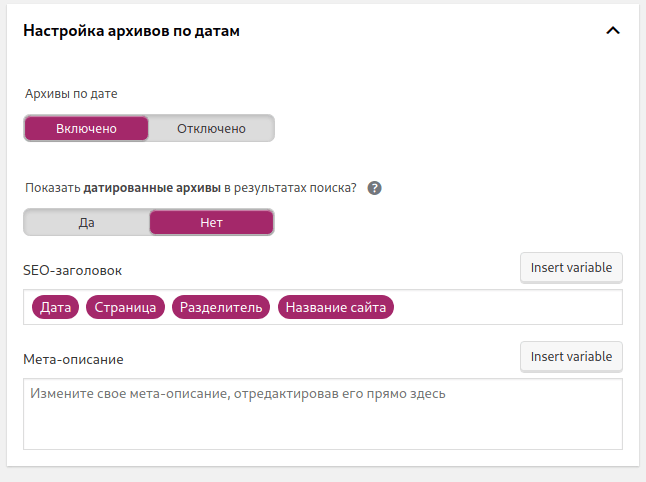

Но если у вас обычный блог на WordPress (как мой), запрещать индексацию необходимо через различные плагины. Самым популярным на данный момент считается Yoast SEO, о которым вы уже наверняка слышали и может даже он установлен у вас. Его внутренних функций вполне хватает для запрета индексации рубрик, меток, архивов.

Идеальный robots.txt, какой он?

Очень много зарубежных вебмастеров ссылаются на то, что файл должен содержать минимум запретов. В том числе и ребята из Yoast SEO в своей статье о robots.txt рассказывают о том, что файл robots.txt должен быть таким:

User-agent: *И больше ничего, кроме этого. А ведь у их плагина свыше 5 миллионов активных установок. Я думаю, что они знают, о чем говорят.

User-agent: * — говорит о том, что инструкции которые следуют ниже, применимы ко всем поисковым роботам. То есть, все что написано ниже, учитывается всеми поисковыми системами (Яндекс, Google, Bing и т.п). А так как ниже у нас ничего нет, то дается полная свобода действий для поисковых систем.

Напоминаю, что рубрики, теги и архивы можно отключить через плагин Yoast SEO. Его настройку я буду разбирать в следующей статье. Считаю, что он должен быть установлен абсолютно на каждом блоге.

Что делать, если вы хотите запретить папку или файл?

Допустим, что на вашем хостинге всё-таки есть такая папка, которую вы хотите запретить для индексации. Возможно вы дизайнер или веб-разработчик, который хранит своё портфолио для работодателей прямо у себя на сервере. Это достаточно удобно, кидать ссылку на свой сайт, а там портфолио. Тогда да, вы можете задействовать команду Disallow.

Допустим, что портфолио находится по адресу site.com/portfolio/, тогда ваш robots.txt должен быть таким:

User-agent: *

Disallow: /portfolio/Аналогично поступаете и с остальными файлами и папками, которые хотите запретить. Хотелось бы сказать, что такие папки как wp-admin или wp-includes поисковые системы сами отлично понимают и не добавляют их в поиск, но просматривают.

Просмотр таких мест необходим. Технологии развиваются и поисковые системы соответственно тоже. Сейчас они визуализируют ваш сайт, при его посещении. Т.е. они видят его так, как видит его обычный человек. Поэтому, запрещая какие-то папки или файлы стилей, вы можете нарушить этот процесс и поисковая система начнет думать, что ваш сайт «кривой».

Карта сайта и главное зеркало

Во-первых, карту сайту сайта и главное зеркало вам следует добавить в самих площадках Google Webmaster и Yandex Webmaster. Но если хочется, то можно указать это и в вашем robots.txt. Так сказать, для подсказки роботу. Host — отвечает за главное зеркало сайта. Sitemap — отвечает за карту вашего сайта.

Например, мой robots.txt выглядит так:

User-Agent: *

Host: https://denidenx.com

Sitemap: https://denidenx.com/sitemap_index.xmlИ меня это вполне устраивает, и судя по всему, поисковые системы тоже. Разделы, которые я хотел скрыть от поисковых систем, я скрыл через плагин Yoast SEO. Но про то, какие категории сайта лучше закрывать, да и в целом то как настроить Yoast SEO, я рассказываю в статье по ссылке.

Напоминаю, что данная настройка robots.txt относится исключительно к настройке блога на WordPress. К интернет-магазинам и сайтам электронной коммерции, данные правила не актуальны. Там задействованы сложные технические механизмы и порой необходимо скрывать от роботов что-то через robots.txt.

Вот в этой статье https://dampi.ru/pravilnyiy-robots-txt-dlya-sayta-na-wordpress автор утверждает о том, что если открыть uploads для всех ботов, то в индексе появляются загруженные PDF и прочие текстовые файлы. А в яндекс вебмастере, в отчете «Исключенные страницы» появляются сообщения об ошибке при индексировании картинок, мол содержимое не поддерживается. Вот и не знаю кому верить…

Если вы загружаете PDF файл и не запрещаете их к индексации, они действительно будут отображаться в поисковиках. Если в них нет ничего секретного, то ничего страшного. Вы можете точечно закрывать неугодные вам форматы файлов через *.

Например: *.pdf